AIが引き起こしたトラブルを、発生したシーンに合わせて理解するリスク解釈技術を開発

2023年4月12日

English

AIはヘルスケア、金融、ものづくりなど様々な分野で活用されています。しかし、データやAIの中にあるジェンダーや人種などについての偏りにより、不公平な判断をしてしまうことが問題視されています。信頼されるAIを推進するため、欧州連合(EU)はAI規制法(AI Act)を数年内に施行する予定です。

今回、富士通はAI倫理リスク解釈技術を開発しました。この技術は、過去にAIが引き起こしたトラブル(インシデント)のレポートを活用することで、概念的な倫理要件をAI活用シーンに合わせて解釈し、インシデントが実際に発生するメカニズムの理解を支援するものです。AI Act(案)に基づく適合性評価を含め、AIのリスク査定において広く活用されることを目指して、発表済みのAI倫理影響評価方式に本技術を導入してツールキット化しました。

これにより、今まで人手に依存していたリスク査定を自動化し、これまで数日要したリスク査定作業を2時間に短縮することに成功しました。

AI倫理、背景と課題

欧州委員会により「信頼されるAIのための倫理ガイドライン」がOECD(経済協力開発機構)により、「人工知能に関するOECD原則(OECD Principles on Artificial Intelligence)」が発表されたことをきっかけに、2019年以降、多くの団体・企業がAI倫理に関するガイドラインを発行しました。これらの文書は、AIが社会と共有すべき価値や規範へ準拠するために、設計、開発、運用フェーズにおいて充足すべき要件を定めています。

2021年4月に公表されたAI Act(案)では、システム提供者が禁止された用途へAIを適用し、高リスクな用途にAIを適用したにもかかわらず適切な監査を実施しないなどの違反に対して、多額の罰金を伴う制裁を科す予定となっています。また、本法案の適用対象には欧州域外から欧州域内にサービスを提供する場合も含まれているため、欧州域外の多くの事業者にも遵守が求められる予定です。

これらの動向を踏まえ、AIシステム開発にあたって倫理原則や開発ガイドラインへの準拠をチェックリストで確認する取り組みが始まっています。しかし、法規制とチェックリストの関連性が不明瞭な場合もあり、法規制に則った適切な査定がこれまで以上に重要となっています。

ところが、こういったチェックリストの多くは多様なAI活用の場面に共通の指針を与えることを目標としているために、その内容が個別のAI活用シーンにおいて何にあたるものか、リスク査定を行う作業者が熟慮する必要がありました。これでは、リスクを評価し、スピーディかつ着実な対策を講じることができず、信頼されるAIの社会実装を加速していくことは困難です。

AI倫理リスク解釈技術

前述したように、AIに携わる多様な関係者(ステークホルダー)がチェックリストを遵守するだけでは配慮すべき倫理要件を不足なくカバーしていることを検証できません。この問題を乗り越えるため、当社は2022年にAI倫理リスクを抽出するAI倫理影響評価ツールを無償公開しました。

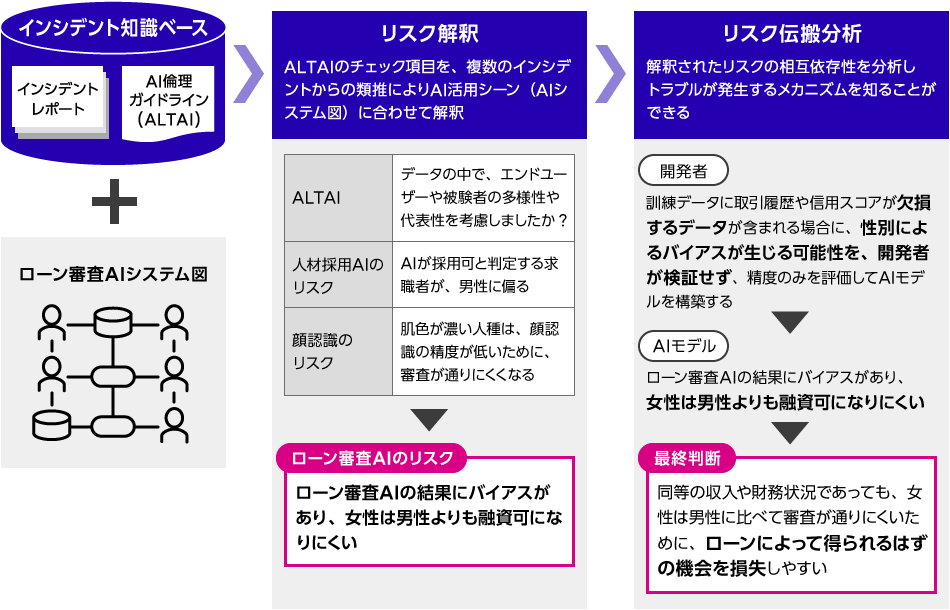

さらに今回、これまでに様々なメディアや事業者により報告されてきたAIが引き起こしたトラブル(インシデント)のレポートを活用し、チェック項目を実際にAI活用のシーンに合わせて解釈したのちに、インシデントが発生するメカニズムを理解できるようにすることで、スピーディな対策の検討を支援するAI倫理リスク解釈技術を開発しました。

この技術のポイントは以下になります。

リスク解釈

インシデントレポートにある数千の文や段落を、150件のチェック項目の中のいずれかと関連づけたインシデント知識ベースを構築しました。これを用いて、AI活用シーンに登場するステークホルダーとその業務、AIモデルとその評価指標、およびデータとその加工手順などの具体的な言葉で、チェック項目の記述をリスクが顕在化する状況に読み替えるためのヒントをリスク査定者に示します。

ローン審査AIの活用シーンを例にとると、「データの中で、エンドユーザや被験者の多様性や代表性を考慮しましたか?」というチェック項目の中で、“エンドユーザや被験者”を“融資を受ける人々”に、“多様性や代表性”を“男性と女性の違い、男性への融資への偏向”に読み替えるというヒントが示されます。

リスク伝搬分析

リスクが顕在化する状況を知るだけでは、これらに対処する施策を講じることは困難です。そこで、再びインシデント知識ベースを用いて、ステークホルダーの間をリスクが伝搬する状況をネットワーク分析します。

ローン審査AIの活用シーンを再び例にとると、信頼されるAIの要件のひとつである公平性に関連するリスクに注目してネットワーク分析をした結果、開発者、AIモデル、融資担当者の最終判断などに潜むリスクの間の依存性を発見することができます。

これにより、リスク顕在化のメカニズムをストーリー化しリスク査定者に提供することで、リスクが顕在化するそれぞれの状況を引き起こす要因が特定できます。

ローン審査AIの倫理リスク解釈処理の流れ

ローン審査AIの倫理リスク解釈処理の流れ

人材マッチングAI分野で技術検証

本技術の有用性を検証するために、岩手県様のUターン・Iターン希望求職者と求人企業をマッチングするサイト「シゴトバクラシバいわて*」のユースケースを対象にAI倫理リスク解釈技術の効果検証をしました。

その結果、当社のAI倫理影響評価ツールが検出した150件のAI倫理リスクのすべてのケースにおいて、発生するメカニズムを理解することができました。AI活用シーンに合わせて検証したことで、AI倫理リスクに対処する適切な施策が過去のインシデントの中から特定され、「ジョブカフェいわて*」で検討してきたすべての施策がAI倫理リスクに対して有用であることが検証できました。

- *シゴトバクラシバいわて: 岩手県様から富士通Japanへ開発・保守・運営を委託

- *ジョブカフェいわて: 岩手県の就労支援施設、岩手県様から富士通Japanへ管理・運営を委託

また、AI倫理リスク解釈技術をツール化し、当社の倫理リスク査定チームに提供したところ、これまで数日要したリスク査定作業を2時間に短縮する効果が確認できました。AI倫理リスク解釈技術を実装したツールキットは、ガイドラインを遵守するためのコスト対効果の問題を大きく低減し、あらゆるAI活用シーンを包括するための共通性の高いチェック項目の内容を、具体的なストーリーへ読み替えることができる効果を確認しました。

開発者コメント

AIトラスト研究センター 開発チームメンバー

志賀 聡子

Shiga Satoko

大橋 恭子

Ohashi Kyoko

佐藤 陽

Sato Akira

新田 泉

Nitta Izumi

小野寺 佐知子

Onodera Sachiko

我々のプロジェクトでは、信頼できるAIの普及をめざし、AI倫理リスクマネジメントの研究を行っています。これからも、倫理的なリスクに不安を感じてAIの利用をためらうのではなく、AI開発者が自信をもってAIシステムを開発し、お客様が安心してAIシステムを利用できることを目指して、技術開発およびその普及に貢献していきます。

今後について

本方式の適用対象となるAIの範囲を拡大し、AI倫理リスクへの対応を強化していきます。また、信頼できるAIの普及に貢献するため、今回開発したツールキットおよびそのノウハウについて、お客様やパートナーをはじめ広く提供するとともに、近い将来施行される予定のAI Act(案)への適合性の評価に活用されることを目指します。

本件に関するお問い合わせ

富士通研究所 AIトラスト研究センター

fj-labs-aie-info@dl.jp.fujitsu.com