第5回:AI運用時の再学習における倫理リスクでは、ローン審査AIを題材に、AIの継続運用の過程で倫理リスクが増幅することもある、という事例をご紹介しました。今回は、ショッピングモールの顔認識AIの事例をご紹介し、倫理リスクを分解して考えるメリットについてお話しします。

顔認識AIの活用事例を見てみましょう

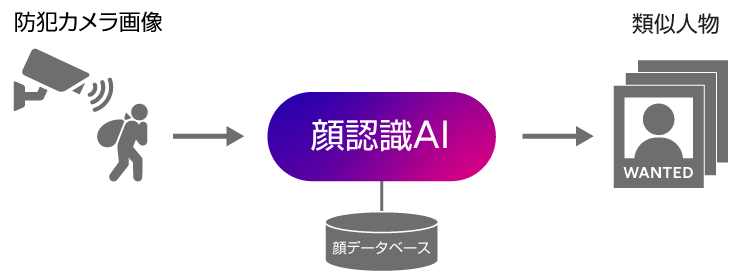

ショッピングモールの警備支援のために、顔認識AIが採り入れられている事例を想定しましょう。たとえば、不審人物や過去にそのショッピングモールでトラブルを起こした人物がいれば早期に把握するために、モール内に設置された防犯カメラに映った人物画像を入力し、顔データベースと照合して、似ている人物の候補を出力するAIです。

類似度スコア順に、類似人物の候補が出てくるイメージです。このような警備支援の顔認識AIの倫理リスクはどこにあるのか、見てみましょう。

顔認識AIの倫理リスクを分析してみましょう

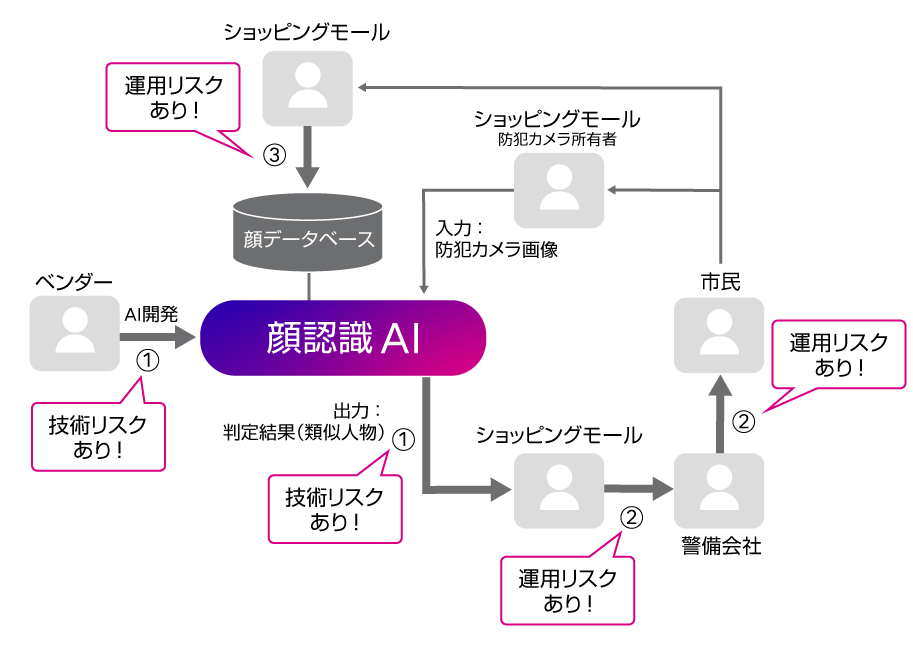

富士通のAI倫理リスク分析技術を用いて、警備支援の顔認識AIの事例を分析してみます。ステークホルダー(登場人物)とAIのインタラクションに着目し、各インタラクションにひそむ倫理リスクを示します。今回は、説明のわかりやすさのために、分析結果を考察し、「技術リスク」「運用リスク」に分類して図示します。

AIの中身に少し触れたことがある方はご存知の通り、AIの判定の精度は100%ではありません。間違った判定結果が出るケースはどうしてもあるのです。これまでの連載回でも繰り返し出てきましたが、たとえばAIが学習するデータに偏りがあり、それを考慮せずにAIを開発したことに起因して、特定の特徴を持つ人の判定に誤りが多くなる可能性もあります(①)。

また、AIから出力された「類似人物」が実際には防犯カメラに映った人物とは異なる人物だった場合に、もし、AIの結果を自動で警備会社に通報し、警備員が駆け付けるような仕組みにしていれば、AIによる誤った判断を信じた警備員が、来店客の行動を監視して不快な思いをさせ、トラブルになってしまうといったリスクがあります(②)。

また、顔データベースはいったいどこからくるのでしょうか。たとえば、そのショッピングモールでのクレジットカードやキャッシュレス決済などの申請に使われた顔写真(本人確認書類)の情報が流用されたらどうでしょう。顔写真を提出した市民は、そんな流用に同意しているでしょうか。また、データには氏名や住所など、顔写真以外の個人情報も含まれているかもしれません。このような情報が警備・通報目的での個人特定に用いられることが、法令違反を含めて、倫理的に問題となる恐れがあります(③)。

こうしてみると、抽出したリスクにも様々な種類があり、たとえばAIの技術的なリスクと、運用上のリスクに分けられることがわかります。運用上のリスクは、仮にAIを別のものに入れ替えても(違うベンダーの開発したAIに替えたり、もっと言うとAI部分を人間が代わりに判定するのだとしても)起こりうる、人間側の使い方に関するリスクですね。

このように、AIの利用シーンにリスクがあるのかないのか、という議論だけではなく、どこにどういうリスクがあるのか分解し、そこから、それはAI自体に由来する技術的なリスクなのか、それとも人の運用上のリスクなのかなど、明確にしていくことが大切なのです。

第1回~第6回のまとめ

これまで、様々な事例を通して、AI倫理の重要性・必要性をお話ししてきましたが、それは、みなさんを脅かすためではありません。AI活用の検討段階からこのような分析を行い、気づきにくいリスクも含めて洗い出すことができれば、AIをうまく活用していく道を具体的に探ることができるのではないでしょうか、とお伝えするべく、この連載記事を書いてきました。

AIはあくまで道具です。いかに使うか、その使い方を考えるのが人間の役目なのです。それは、AIを開発するベンダーだけが考えるのではなく、関係するステークホルダーがそれぞれ、いい知恵を出し合ってこそ、うまくいくのです。

この先も、AIをうまく使っていくためのAI倫理について、みなさんと一緒に考えていきたいと思っています。AI技術はどのようにあるべきなのか。そして、我々はAIをどう使うべきなのか。富士通は、信頼できるAIを作るだけではなく、AIと共生する社会についても考えていきます。

我々の研究に興味を持っていただけた方がいらっしゃいましたら、ぜひ、お気軽にお問い合わせください。