第2回:かくれ属性の影響では、人材採用AIの事例を用い、AI倫理を考える上では、AIが直接的に使用するデータ属性だけではなく、かくれた属性の影響についても考慮する必要がある、というお話をしました。今回は、AIを活用した再犯予測についての事例をご紹介します。

再犯予測AIの活用事例を見てみましょう

近年、重大な社会問題の解決においても、AIを取り入れようというケースがあります。人間が行う判断において、属人化を避け一貫性を保つために、AIの判定結果を参考にするタイプの利用シーンです。その一例として、裁判所での再犯予測の利用シーンを考えます。まずAIは、過去の被告人・再犯者のデータを学習します。そして、新たな被告人のデータが入力されると、再犯の可能性(再犯リスクスコア)を10段階評価で予測します。

このような再犯予測AIが、米国では実際に採用されています。懲役何年か、執行猶予を付けるのか、保釈するのかなど、裁判官が判断を下す際の一つの参考情報にされているのです。あるとき、これが大きな論争を巻き起こしました。あるメディアが「再犯予測AIが人種差別を行っている。白人に比べて黒人は再犯リスクが高いと判断されるバイアスがかかっている」と独自の調査結果を公表したのです(注1)。第2回で、不公平があってはならない「センシティブ属性」について述べましたね。人種もセンシティブ属性の一つです。この再犯予測AIの学習・判定でも、人種の情報はマスキングされ、使われていないとされていました。しかし、そのメディアの調査結果によると、実際には再犯しなかったにもかかわらず、黒人は白人の約2倍の割合で、再犯リスクが高いと誤判定され(偽陽性)、逆に実際に再犯したケースでは、白人は黒人よりも約2倍の割合で、再犯リスクが低いと誤判定されていた(偽陰性)、というのです。それに対し、再犯予測AIを開発したベンダーは、再犯リスクが高いとされる割合は白人と黒人で違いはない、と検証レポートを提出し反論しました(注2)。

この論争には、告発したメディアとAI開発ベンダー以外にも、統計やデータ分析の専門家なども加わり、白熱した議論がなされました。そもそも実際の被告人の数において人種間の偏りの問題があり、司法の仕組みそのものへの疑問も投げかけられました。そして、論争は今(本記事執筆時点)も解決していません。

再犯予測AIの倫理リスクを分析してみましょう

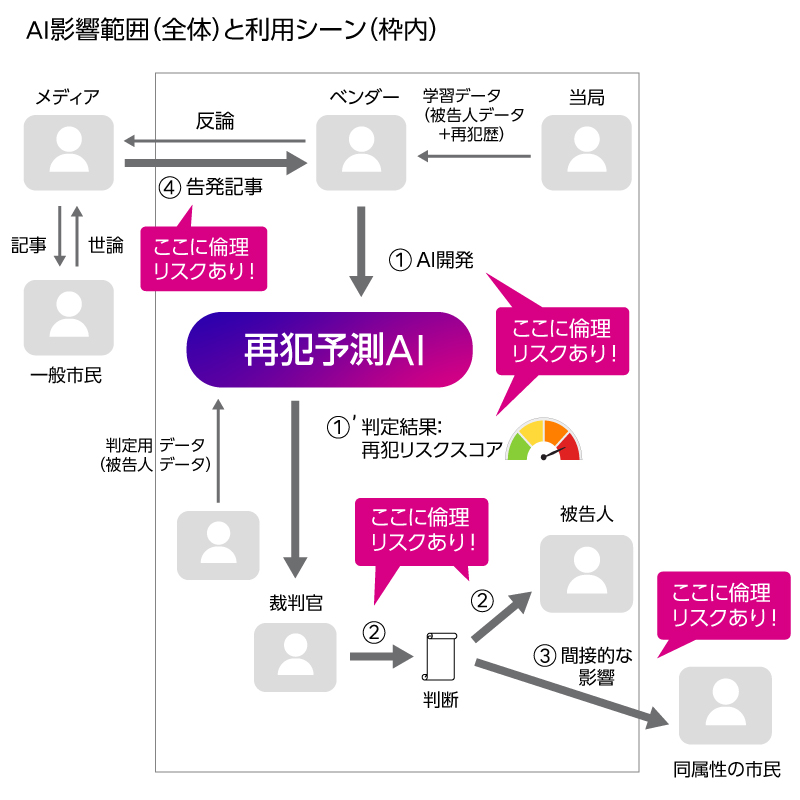

ここで、富士通のAI倫理リスク分析技術を用いて、本事例を分析してみます(注3)。ステークホルダー(登場人物)とAIのインタラクションに着目し、各インタラクションにひそむ倫理リスクを示します。

AIの開発者がベンダーで、AIの利用者が裁判官、AIの判定対象が被告人です。被告人に関する調査をもとに、100以上の項目がAIへ入力され、裁判官はAIによって判定された再犯リスクスコアを得て、判断を下す際の参考にします。被告人のデータは、今後の再犯予測AIの学習データにもなります。AIの直接的な利用シーン(枠内)に登場するこれらの人々に加えて、今回の事例の場合、さらに問題を告発したメディアと、市民が関係してきます。市民には、被告人と同じ地域に居住するなど共通する属性を持つ市民(同属性の市民)と、それ以外の市民(一般市民)がいます。論争に参加した専門家も一般市民にあたりますね。実は、分析図の登場人物には、AIの利用シーンに直接は登場しなくても、間接的に影響を与える・受ける人物もステークホルダーとして含まれるのです。

本事例でAI倫理リスクがあるのは、図内の矢印①~④の部分です。本来、被告人に対する量刑の判断に、罪の重さや再犯可能性とは関係のない、人種や地域性といった要素は結びつけられるべきではありません。しかし、枠内の①、AI開発ベンダーからAIに伸びた矢印の部分において、AIが学習した過去の被告人データの人種に偏りがある可能性があります。そして、AIが使用するデータにおいて、人種など倫理的に懸念がある情報はマスキングされたとしても、マスキングされたはずの情報がたとえば被告人の居住地域など他の情報から思いがけずにじみ出てしまい、AIの判定結果に影響してしまう「かくれセンシティブ属性」問題が発生することがありえます。それによって、①‘のAIから裁判官への矢印部分において、AIの判定結果が差別的なものになってしまう可能性があります。

次に枠内の②、裁判官が被告人に出す判断の部分です。もしも裁判官がAIの出す再犯予測結果を過信した場合、それによって従来の判断よりも重くなってしまうなどの可能性があります。

そして、枠外の③、被告人と同じ地域に居住するなどの、同属性の市民へ影響があるおそれもあります。被告人への判断を見た人に対し、その被告人と同じ属性を持つ人は犯罪に走りやすいといった誤解を与え、差別を助長してしまうことがあるかもしれないのです。

さらに、枠外の④、メディアからベンダーに伸びた矢印の部分です。メディアは第三者ですが、AIの人種差別問題を公表し、開発ベンダーを名指しで告発することがあります。そして、世界中のメディアや一般市民の関心をも集め、司法のあり方にまで議論が及ぶことがあります。こうして、AIの直接的な利用シーン(枠内)に閉じず、大きな社会問題に発展していくこともあるのです。

AI倫理リスクにおける「間接的ステークホルダーの存在」

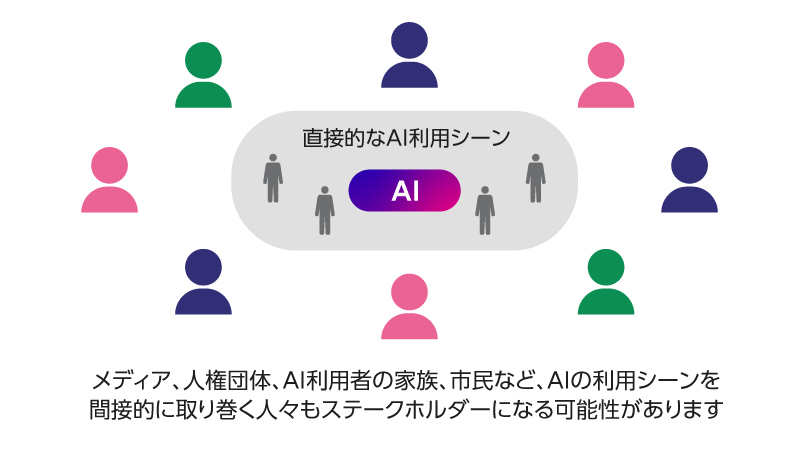

このように、AI倫理の影響範囲はAIの直接的な利用シーンよりも広く、利用シーンの外にいる「間接的ステークホルダー」も含めて広く洗い出して考慮する必要がある、と覚えておいていただければと思います。今回の事例では、メディアや市民が間接的ステークホルダーですね。実際はもっと細かい図を使って分析しており、ここに挙げた以外のインタラクションに紐づく倫理リスクも見えてきます。こうして、AIの直接的な利用シーンの外にも広げてAI倫理リスク分析を行うことによって、どこに倫理リスクがあるのか見えてくれば、事前にそこに対処し、AIをうまく使っていくことができますね。

AI倫理リスクを理解するには、さらにいろいろな事例を見ることが役に立ちます。本連載でその勘所を掴んでいただければと思います。次回、別の事例もご紹介します。

もし、我々の研究に興味を持っていただけた方がいらっしゃいましたら、ぜひ、お気軽にお問い合わせください。