まず、どうしてAI倫理を考えなくてはいけないのでしょう?もちろん、EUのAI規制法案(AI Act) 注 やAI利用に関する各種ガイドラインなどが各国政府・団体において制定されつつあり、ビジネスをする上では考慮が避けられないところにきている、という社会状況があります。他にも、AI倫理を考えるべき理由、気を付けるポイントは様々ありますが、今回は、みなさまによりAI倫理問題を身近に感じていただくために、そのうちの一つ「利用シーンによって変わる倫理リスク」について、お話ししたいと思います。

ここで、果物の画像をもとに、等級判定するAIを想定します。ベルトコンベヤーで流れてくる果物の画像が入力されると、「特選、秀、優、良、なし」の5段階に分類するラベルを出力するAIです。

これを、個人の農家Aさんが自分の出荷のために使うとします。人が最終確認しないと、多少誤った判定結果があるかもしれないという、AIの精度の問題はあるかもしれませんが、倫理的には、特にトラブルなく使えそうです。

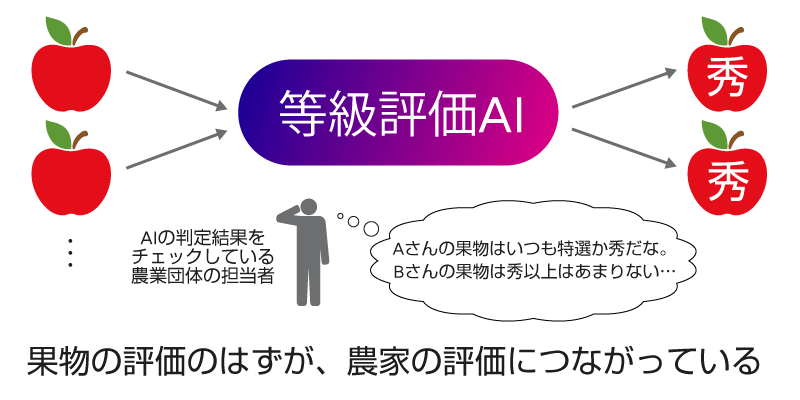

次に、同じAIを、農業団体で利用するシーンを考えてみましょう。農業団体には、農家Aさんの果物、農家Bさんの果物、…多くの農家さんの果物が集まってきます。AIが行うのは、先ほどとまったく同じ、果物の画像が入力されたら、等級を出力する、というアクションです。ですが…おやおや?以下のようなことが起こりえませんか?

もし、AIが行った、果物一つひとつの判定結果が、農家ごとに集計されたりすると(たとえば農業団体から農家に支払う代金計算のために)、それがいつの間にか、農業団体にとって農家を評価する話につながってしまい、今後の取引や融資にまで影響しかねません。仮に、AIの等級判定結果が、そのまま融資判断の材料として活用されるといったことが起こった場合、果物を出荷した農家の方は受け入れられるでしょうか?もし知らないうちに行われていたとしたら?農家さんと農業団体の間でトラブルになる恐れがありますよね。

このように、使っているAIは全く同じでも、その利用シーンが変わることで考慮すべき倫理リスクが変わることがあることを、この記事でみなさんにお伝えしたいのです。AIの中身だけを近視眼的に見ていては、AIをとりまく倫理問題には対処できません。単体ではすごく良いAIができた!技術者としては満足!でも、いざ使おうとしたら大炎上なんてこと、回避したいですよね…。AIをリアルに使うというのは、ここまでひっくるめて考えるということなのです。

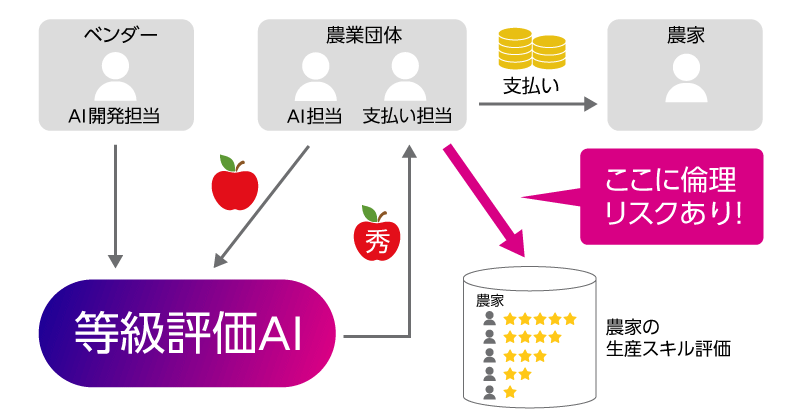

これ、言い換えると、AIの利用シーンに登場する人物、いわゆる「ステークホルダー」の違いによって、倫理リスクが変わる、と言ってもよいですね。先ほどの果物等級判定(農業団体版)のシーンで考えられるステークホルダーを挙げ、AIとの関係を図に表してみます。

人のマークがステークホルダー、矢印はステークホルダー間およびステークホルダーとAI間のインタラクションです。このインタラクションに、倫理リスクを紐づけて表現しています。このシーンで倫理リスクがあるのは、農業団体の右側の支払い担当から農家の生産スキル評価にのびた、太い矢印の部分であることがわかります。富士通では、このように、ステークホルダーとAIのインタラクションに着目し、各インタラクションにひそむ倫理リスクを示す、AI倫理リスク分析技術を開発しています。実際はもっと細かい図を使って分析していくのですが、技術の詳しい話は、また別の場でご紹介しますね。こうして、AI倫理リスク分析によって、どこに倫理リスクがあるのか見えてくれば、事前にそこに対処し、AIをうまく使っていくことができますね。

今後も、AI倫理リスク分析技術を用いた分析結果を事例集としてまとめていきますので、さまざまな事例を数多く見て、AI倫理で気を付けるべきポイントの勘所を掴みましょう。そして、AIの適切な活用方法を考え、信頼されるAIを作っていきましょう。

もし、我々の研究に興味を持っていただけた方がいらっしゃいましたら、ぜひ、お気軽にお問い合わせください。