第4回:AIに学習させたくないデータの存在では、チャットボットAIの事例を用い、ユーザーの悪用や誤用をシナリオとして考慮せず、ユーザー入力をそのまま学習データに取り入れ出力に用いることには注意が必要である、というお話をしました。今回は、AIを用いたローン審査を題材に、AIの継続運用にあたって必要となるメンテナンスの品質によっては倫理リスクが増幅する恐れがある、という事例をご紹介します。

ローン審査AIの活用事例を見てみましょう

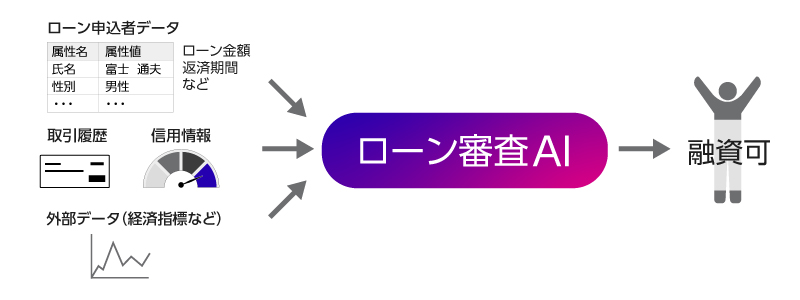

金融機関でのローン審査において、審査時間を短縮でき、属人化しない安定した審査基準を保つことができる、ローン審査AIが採用されているケースを想定しましょう。ローン申請者が自身の情報やローン金額、返済期間を入力すると、金融機関がその申請者の取引履歴や信用情報、外部の経済指標などをあわせてAIに入力し、AIが融資の可否を出力します。

あるとき、このAIの審査結果に、性別や人種などによる不公平があるのではないか、と問題になりました。AIに学習させるデータの偏りを一因として、意図せずこのような不公平が生まれてしまう事例をこれまでの連載回でも紹介してきましたが、同様のことが考えられます。

今回はさらに、AIを継続的に運用することから生じる新たなリスクについても目を向けてみます。AIを運用していると、AIをとりまく社会情勢や市場動向が徐々に変化することにより、AIの学習時とAIの審査実行時のデータ傾向が変わってきてしまい、初期の学習(運用開始時)から時間がたつにつれて、AIの精度が低下してしまうことがあるのです。この問題を防ぐため、社会実装されるAIは、運用開始後にも、定期的に再学習するなど、継続的にメンテナンスをすることが必要になってきます。金融業界は変化が激しく、メンテナンスが欠かせません。ローン審査AIの再学習では、最新のローン利用者についての情報を学習データとして用い、最新のデータトレンドに追従していく必要があります。さて、この運用方法のどこにリスクがあるのでしょうか。

ローン審査AIの倫理リスクを分析してみましょう

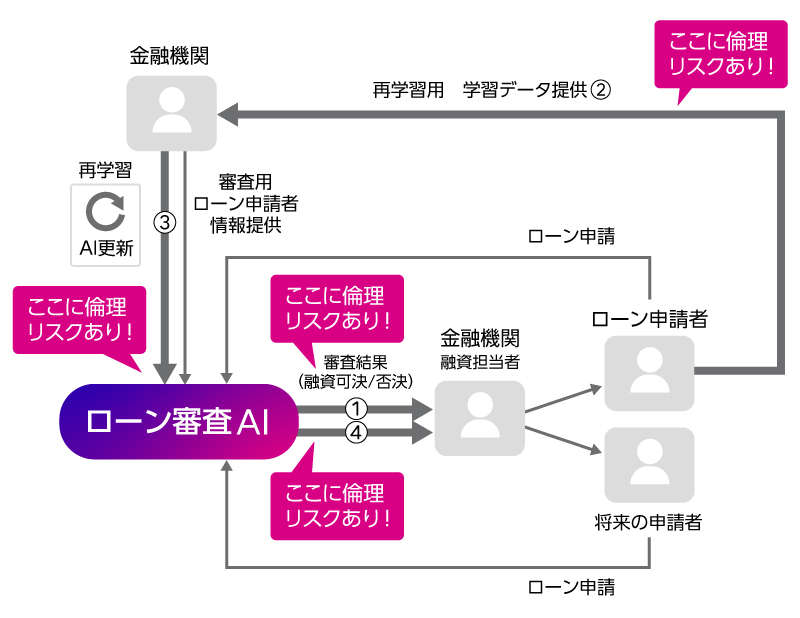

富士通のAI倫理リスク分析技術を用いて、定期的なメンテナンス(再学習)を行っているローン審査AIの事例を分析してみましょう。ステークホルダー(登場人物)とAIのインタラクションに着目し、各インタラクションにひそむ倫理リスクを示します。

今回は、AIの運用開始後の再学習まで考えますので、考慮する要素が多くなりますが、AIの審査結果が出た後、再学習に関係する部分に注目して、わかりやすく図解します。

参考:

AI開発からAIの審査結果出力までのリスク分析について:たとえば、人種や性別などによる意図しない不公平がそもそもある人間の審査結果がAIの学習データになっている、AI開発においてこれらの不公平が見逃されたままで学習が行われている、そのためAIから示される判定結果に不公平が生じるなど、

過去の連載回における不公平なAIの事例と同様なリスクが考えられます。

はじめに、ローン審査AIから示される判定結果に不公平が生じるリスクがある(①)というところから見ていきましょう。そして、AIが判定した融資可否を参照し、融資が実施されます。金融機関はその後、そのローン申請結果の情報を、最新の学習データとして、再学習に活用していきます(②)。ここでもリスクが発生するのです。次の再学習用の学習データにも再び、偏りが生じる可能性があるというリスクです。たとえば、融資可と判定された人については、融資実績が生まれますので、その後の結果として、実際に返済できたか(今後も融資可)、できなかったか(今後は融資不可)という実績ベースで再学習用の学習データに追加されるとします。一方、①で融資不可と判定された人についてはどうでしょう?融資は実施されないのですから、実際の返済能力の情報がありません。①で融資不可とされた人が、そのまま「融資不可」というラベルをつけられて②の再学習用の学習データに追加された場合、不公平の修正の可能性が低くなります。

このような再学習用の学習データをもとに、また不公平が見逃された再学習が行われるとすると(③)、更新されたAIから将来のローン申請者に提示される判定結果は、さらに不公平が強まったものになる恐れがあるのです(④)。こうした再学習が繰り返されて、気づかないうちに、不公平が増幅し続け、特定の特徴を持った人々には融資のチャンスがなくなる、といった現象も起こりかねないのです。

AI運用時の再学習における倫理リスク

いかがでしょうか。これはかなり単純化した説明であり、実際のローン審査AIはこんなに安直ではないですが、もし、AIが出す結果の倫理リスクを検証せずに、再学習を継続する形がとられていくと、リスクが増幅し続けてしまう可能性があることを、覚えておいていただきたいと思います。

AIの社会実装が進む中、ある時点での開発のことだけではなく、その先の継続運用・メンテナンスの品質のことまで考える、「AIライフサイクル」の考慮(注2)が必須になってきています。再学習に伴うリスクは、AIの実用上、決して無視できない視点として、意識していただければと思います。

実際はもっと細かい図を使って分析しており、ここに挙げた以外のインタラクションに紐づく倫理リスクも見えてきます。こうして、AI倫理リスク分析を行うことによって、どこに倫理リスクがあるのか見えてくれば、事前にそこに対処し、AIをうまく使っていくことができますね。

AI倫理リスクを理解するには、さらにいろいろな事例を見ることが役に立ちます。本連載でその勘所を掴んでいただければと思います。次回、別の事例もご紹介します。

もし、我々の研究に興味を持っていただけた方がいらっしゃいましたら、ぜひ、お気軽にお問い合わせください。