生成AIをはじめとするAI開発競争の激化により、AI処理に最適とされるGPUの需要が急増しています。世界的なGPU不足の解決に向け、富士通は2024年の10月に、AI処理におけるGPUを最大限活用する技術「AI computing broker(以下、ACB)」の提供を開始しました。ACBは、AI アプリケーションに対して GPU を自動的にリアルタイムに割り振り、アプリケーション実行全体よりも細かい単位で GPU の割り当てを管理するための技術です。AI 処理に必要な GPU 数を大幅に削減、電力消費およびAI 開発・運用コストの低減に貢献します。本記事では、ACBの研究チーム4名に、進行中の実証実験や技術開発における挑戦などについてインタビューしました。

2025年3月31日 掲載

RESEARCHERS

-

宇治橋 善史

Ujibashi Yoshifumi

富士通株式会社

富士通研究所

コンピューティング研究所

Computing Workload Broker CPJ

プリンシパルリサーチャー -

田渕 晶大

Tabuchi Akihiro

富士通株式会社

富士通研究所

コンピューティング研究所

Computing Workload Broker CPJ

プリンシパルリサーチャー -

栗原 康志

Kurihara Kouji

富士通株式会社

富士通研究所

コンピューティング研究所

Computing Workload Broker CPJ

リサーチャー -

高品 剛大

Takashina Godai

富士通株式会社

富士通研究所

コンピューティング研究所

Computing Workload Broker CPJ

リサーチャー

GPU不足と消費電力問題を解消するACB

ACBを開発した背景を教えてください。

宇治橋:世界は今、AI開発の競争が激化しています。AI処理に必要なGPUは需要が急増し、GPU不足は深刻な問題です。価格は高騰し、調達にも時間がかかります。たとえ優れた技術を持っていてもGPU不足によって開発が遅延したり、AI処理に必要な環境を構築できなかったりする可能性があります。さらに、消費電力は、2030年には世界の電力需要の10%にもなるとの推定があり、環境への負荷が懸念されています。原発の導入を検討する企業も存在するほど消費電力は深刻な問題となっています。GPU不足と消費電力問題、この大きな課題を同時に解決するのが、我々のACBです。この技術は、AI処理に必要なGPU数を大きく削減し、かつ、コストと電力も大幅に低減することで、持続可能なAIの実現に貢献します。

どのような活用事例やユースケースがありますか。

宇治橋:ACBの想定利用者は、AIサービスを提供する事業者、データセンターやクラウド事業者などです。GPUを用いた計算インフラの上でAI処理を複数実行する環境において、計算資源の効率的な運用を支援し、AI処理に必要なGPU数を削減します。為替予測AIサービス提供事業者であるトレーダム様との実証実験では、本技術をモデル開発プロセスに適用した結果、演算処理効率が約2倍に向上しました。また、タンパク質の3D構造を予測するAIであるAlphaFold2に適用したところ、従来の半分のGPU数で同じ演算処理効率を達成しました。

宇治橋は、ACB全体的な設計、開発指針の決定を担当するリーダー的な存在

宇治橋は、ACB全体的な設計、開発指針の決定を担当するリーダー的な存在実証実験で技術の価値を確認できたとお聞きしました。

宇治橋:場面によって異なる技術の価値を確認できました。AI処理は、時間のかかる学習処理と、迅速な応答が必要な推論処理(学習した内容に基づく予測や判断)の2パータンの処理があります。トレーダム様は両方のAI処理を行っています。学習処理の場合、ACBを使用することで、AIモデル生成に必要なGPU計算資源の利用を最適化し、精度の高いモデルを短期間で開発できる可能性を確認しました。推論処理については、Webサイトで利用できるAIサービスの迅速な応答に寄与できることが確認できました。ユーザのアクセスが集中した場合、ACBは計算資源の割り当てを学習処理から推論処理へ切り替えることで、サービスの応答性を維持します。これにより、学習処理が行われている間でも、推論処理を滞りなく実行することができます。

プログラム処理を踏まえてGPUの演算効率を高める

ACBの強み・特徴について教えてください。

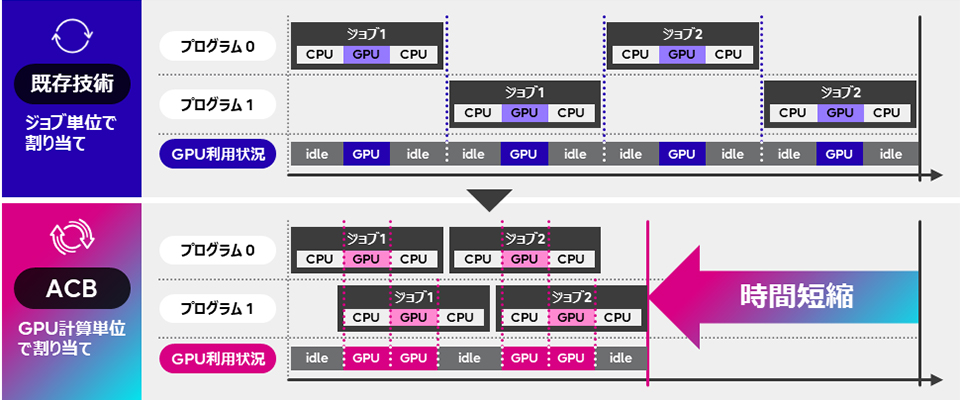

高品:既存技術は、プログラムが実行する作業の単位であるジョブ毎にGPUを割り当てています。プログラム0のジョブ1とジョブ2、プログラム1のジョブ1とジョブ2が、それぞれ順番にGPUを使用しています。このため、GPUを使わない時間(idle:例えば、GPU を利用しない前後処理、他のシステムからや人からの入力待ちなど)が発生し、GPUの利用効率が低いことが分かります。一方、ACBはGPU計算単位で割り当てています。GPUの空き状況に応じてプログラム0と1にGPUを割り当てることで、GPUの利用効率を向上し、全体的な処理時間を短縮しています。本技術はプログラムの処理内容に踏み込み、GPUを利用する処理のみにGPUを割り当てることで、GPU資源を効率的に割り当てることにより、隙間なくGPUを利用できます。

ACBの強み・特徴

ACBの強み・特徴また、今回開発した技術は、ハードウェアやソフトウェア環境への依存をなるべく減らした設計となっています。具体的には、一般的に利用されているPyTorchようなAIフレームワークをそのまま使えるようにしています。AIフレームワーク自体をカスタムして同様の機能を実現することも可能ですが、この方法の場合ユーザーがカスタム版のAIフレームワークを使用する必要があり、AI フレームワーク本体に日々追加される最新機能を利用できない可能性があります。我々の技術では一般的なAIフレームワークをそのまま利用するため、それらがインストールされている環境であればすぐに導入でき、AIフレームワークを更新すれば最新のハードウェアに対応したり追加機能を利用できたりするなど、利用者にとって使用しやすいという利点もあります。

コードをカスタマイズしなくても簡単に利用できる

ACBを使いやすくための工夫を教えてください。

栗原:ACBをより使いやすくするため、お客様からのフィードバックを活用して改善を行いました。実際にお客様に利用していただいたことで、想定外の課題が見つかり、開発の優先順位を見直すきっかけとなりました。例えば、当初はGPUの割り当てを変更するたびにプログラムを再起動する必要があり、非常に不便というご意見を頂きました。そこで、プログラムを停止せずにGPUの割り当て変更ができるように設計を見直しました。また、インターフェースについても、直感的に操作できるように改良しました。さらに、技術を使用するにはお客様自身でプログラムのコードをカスタマイズする必要があり、マニュアルを見ても難しいという課題も浮き彫りになりました。この問題を解決するために、お客様がコードを修正しなくてもACBを使えるようにする自動適用機能を開発しました。

栗原は、実証実験の対応をメインに、機能開発も担当

栗原は、実証実験の対応をメインに、機能開発も担当ACBの自動適用機能の開発における課題を教えてください。

田渕:自動適用機能とは、プログラムのコードを修正することなくACBを使える機能です。この機能を実現するためには、3つの課題をクリアしなければなりませんでした。まず、プログラムがGPUを使う時にのみGPUを割り当てるには、プログラムがいつGPUを使いはじめ、いつ使い終わるかを検出しないといけません。次に、プログラムは通常、GPUのメモリをすべて利用できる前提で書かれているため、GPUで実行するプログラムを切り替える際には、GPUメモリ上のデータをCPUに退避し、GPUメモリを解放する必要があります。さらに、複数GPUを持つシステムでは、利用可能なGPUがタイミングによって変化するため、どのGPUが割り当てられてもプログラムが正しく動作するようにする必要もあります。

それらの課題をどのように解決しましたか。

田渕:課題を解決するためには、AIフレームワークの動作を理解し活用することが重要です。AIフレームワークとは、AIモデルの開発や実行を支援するためのソフトウェア基盤です。まずAIフレームワークの処理を監視して、プログラムがGPUを使用するタイミングを検出します。次に、AIフレームワークが使用するGPUメモリを管理し、プログラムを切り替える際にGPU上のデータをCPUに退避させ、適切なタイミングでGPUに戻します。最後に、どのGPUが割り当てられてもプログラムが正しく動作するように、AIフレームワークが利用するGPUを、実際に割り当てられたGPUに置き換えます。これにより、プログラムからは常に同じGPUを利用しているように見せることができます。

田渕は、自動適用機能やデモ開発を担当

田渕は、自動適用機能やデモ開発を担当デモ展示からも、課題を発見したとお聞きしました。

田渕:我々は、ACBの優位性を示すため、複数の大規模言語モデル(LLM)を同じGPUで実行するデモを行いました。通常、GPUメモリが十分にない場合、複数のLLMを同じGPUで実行することはできません。このデモは、ACBによって、GPUメモリが十分にない場合でも、GPU上でAIモデルを切り替えながら実行し、複数のLLMを同じGPUで実行できることを示しました。このデモを通して、LLMのような巨大AIモデルを利用する際に、AIモデルの転送時間が長くなり、切り替えオーバーヘッド(プログラムを実行するときに間接的に生じる負荷)が大きいという課題があることが分かりました。技術が優れていても転送時間が長ければ、デモでの印象が悪くなるだけでなく、そもそもお客様にとって使いやすい技術とは言えません。我々は転送方法を見直し、不要な転送も削減しました。具体的には、GPUとCPU間のデータ転送においてハードウェア機能を活用した高速な方法に書き換えました。さらに、LLMの推論処理では、 GPUでAIモデルは変更されないため、GPUからCPUへのAIモデルの転送は不要です。そこで、 推論用のAIモデルに関してはCPUに常に保持しておき、GPUで推論処理する際にはGPUへの転送のみ行い、GPUからCPUへの転送を省略しました。このようにすることで、切り替え時間をおよそ10分の1に削減でき、ACBの使い勝手を向上させることができました。

開発ツールの活用とチーム連携で実現する迅速な研究開発

研究の進め方について教えてください。

高品:メンバーは基本的にリモートワークのため、オフィスで顔を合わせる機会は少ないですが、様々な工夫により迅速に開発を進めています。具体的には、毎日の朝会で、困っていることを共有して議論したり、GitHub(ソフトウェア開発のプラットフォームで、プロジェクトやソースコードの管理を行える)上で未解決のタスクを確認したりするなど、メンバー間で密に情報共有し、連携して開発を進めています。また、CI (Continuous Integration:コードチェックの自動化により品質を確保しながら、開発スピードを向上させる開発手法) などの開発ツールも活用しています。CIにより機械的に検出できるバグなどの問題検出は自動化し、レビューの負担を減らしつつコードの品質と信頼性を向上させました。

高品は、機能開発を担当、学会発表や展示会にも対応

高品は、機能開発を担当、学会発表や展示会にも対応面白い出来事があったとお聞きしました。

宇治橋:田渕がSC24(スーパーコンピュータに関する世界最大規模の国際会議)という展示会出展のためアメリカに出張していた時のことです。ある推論用マイクロサービスにACBを適用できるかどうかの検証依頼が急に入り、短期間で対応することになりました。高品と、アメリカ出張中の田渕がメインの担当者でした。そこで、時差を利用しました。アメリカで田渕が展示会の対応の合間に作業してGitHubで共有、アメリカが夜の間に高品が日本で作業し、またアメリカで田渕が作業を行うことを繰り返しました。しっかりと情報共有し、時差を利用することで1週間という短納期で検証をおこないました。イレギュラーなケースでしたが、二人の高い技術力とチームプレイ、そしてスムーズな情報共有で対応することができました。

汎用化し、多くの人が簡単に使用できる技術開発に向けて

ACBの今後の展望について教えてください。

栗原:ACBをより多くの人に使ってもらうためには、対応するハードウェアを増やす必要があります。AI開発で使用される様々なフレームワークに対応したノーコード版の検討も進めており、これにより利用のハードルを下げ、より多くの人に使ってもらいたいと考えています。

田渕:私は、開発を担当した自動適用機能の対象プログラムを拡大し、オーバーヘッドの削減をより強化していきたいと考えています。ACBを汎用化し、より多くの人が簡単に使える技術にしていきたいです。

高品:現在、ACBを複数サーバで連携して動作させるための機能拡張と安定化に取り組んでいます。複数の物理サーバを連携させる必要があり、通信の複雑化など技術的な課題も多く、非常にチャレンジングな作業です。しかし、難しい課題へ取り組むことは自身の成長にも繋がり、大きなやりがいを感じています。

宇治橋:目指すのは、技術をより汎用的に使えるようにすることです。具体的には、現在、AIフレームワークがPyTorchやTensorFlowに限られているため、その範囲を広げたいと考えています。また、AI処理全体を高速化・効率化するなども視野に入れています。今後も、より多くのクラウドサービス事業者などのGPU資源提供者に本技術を提供し、AIによるお客様のビジネスの生産性の向上に貢献したいと考えています。

ACBについてもっと知りたい場合、どのような方法がありますか。

栗原:ACBのデモ動画は、こちらをご覧ください。実証実験にご興味をお持ちの方は、ぜひお問い合わせください。富士通の他の先進技術を体験してみたい方については、Fujitsu Research Portalもご覧ください。

当社のSDGsへの貢献について

2015年に国連で採択された持続可能な開発目標(Sustainable Development Goals:SDGs)は、世界全体が2030年までに達成すべき共通の目標です。当社のパーパス(存在意義)である「イノベーションによって社会に信頼をもたらし、世界をより持続可能にしていくこと」は、SDGsへの貢献を約束するものです。

本件が貢献を目指す主なSDGs