映像データの高品質・効率的な配信に向けて、暗号化パケットデータからユーザー体感品質を高精度でリアルタイムに推定するAI技術を開発

2023年10月2日

English

YouTubeなどの動画配信サービスでは、フルハイビジョンや4Kといった高解像度の映像コンテンツが増加しています。2022年には映像データが、無線でインターネット接続するモバイルネットワークを流れるデータの70%以上を占め、今後もますます増えると予想されています。

今回、富士通は、ユーザーが感じる映像品質の満足度を示すユーザー体感品質(QoE: Quality of Experience)を高精度・リアルタイムに推定するAI技術「Realtime Quality of Experience Sensing」を開発しました。開発した技術によりQoEを算出し、無線ネットワークの運用指標として利用することで、ユーザーが満足する品質を実現するための適切な無線リソースを割り当てることができます。これにより、大容量の映像データの高品質かつ効率的な配信が可能になります。

本技術は、スペインのマドリードで10月9日~10月11日に開催されるネットワーク技術の年次イベントFYUZ![]() で展示します。

で展示します。

5G時代のネットワーク運用

モバイルネットワークで大容量の映像データを高品質に配信するためには、無線リソースを適切に確保することが必要です。従来、移動体通信事業者は、通信速度などのネットワーク品質(QoS: Quality of Service)を満たすように無線基地局などの設備の増強を行ってきました。今後、増え続ける大容量の映像データを遅延なく配信するためには、更に膨大な無線基地局の設置とそれらの適切な運用をしなければなりません。

一方で、ネットワーク運用の新しい指標として、ユーザーのサービス利用に対する満足度を表すユーザー体感品質(QoE: Quality of Experience)が注目されています。リアルタイムにQoEを算出し、ネットワーク運用を保証する指標とすれば、無線基地局を莫大な費用を投じて過剰に設置しなくてもネットワーク品質を保てるようになります。

ユーザー体感品質(QoE)算出の課題

映像などのメディア品質を評価するQoEの1つに、平均オピニオンスコア(MOS: Mean Opinion Score)という値があります。MOSは人の知覚特性を考慮したユーザーのサービスに関する主観的な評価値であり、その値とユーザーの品質への満足度との関係が実験的に明らかとなっているため、品質への満足度の過不足を知るための指標として最適です。

従来、MOSはユーザーへのアンケート調査によって算出されていました。近年は映像アプリケーションから、1秒あたりのデータ量を示すビットレートなどの客観的なメディア品質情報を取得し、映像と音声の品質を評価する国際標準規格ITU-T P.1203を用いて推定できるようになりました。ところが、この方法はメディア品質情報を取得するインターフェースがないアプリケーションには適用できません。また、アプリケーションの再生バッファ内の映像データが減少した際にダウンロードする10秒程度の映像ファイル単位でしかMOSを推定できません。このように、ITU-T P.1203は、多様な映像サービスの品質変化にタイムリーに追従するきめ細かなネットワーク運用に適用することは困難です。

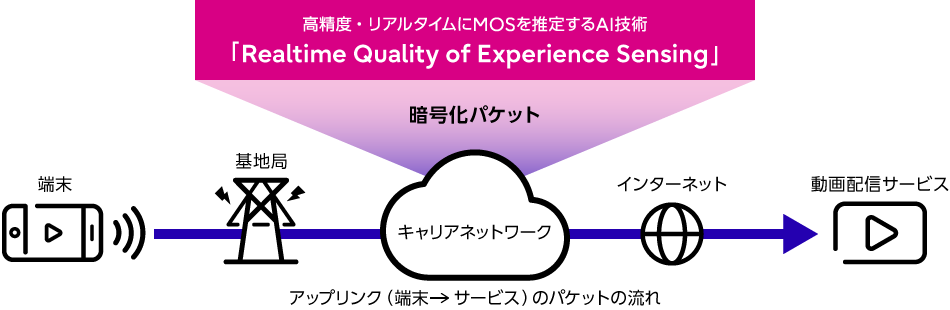

「Realtime Quality of Experience Sensing」を開発

今回、端末と動画配信サービスの間を流れる暗号化されたアップリンク(無線通信で端末から動画配信サービスへ向けた通信)のパケットのみから、高精度・リアルタイムにMOSを推定するAI技術「Realtime Quality of Experience Sensing」を開発しました。本技術はアプリケーションからメディア品質情報を取得する必要がなく、1秒毎にMOSを推定できるため、ネットワーク運用へのMOS適用を実現できます。

図1:「Realtime Quality of Experience Sensing」の全体像

図1:「Realtime Quality of Experience Sensing」の全体像

以降で、本技術の特長を説明します。

・多様なサービスへの対応を可能とするアーキテクチャ

現在、多くの動画配信サービスでは、通信プロトコルとしてHLS (HTTP Live Streaming)やMPEG-DASH(Dynamic Adaptive Streaming over HTTP)を使っています。しかしサービスによっては個別にチューニングや、新しいプロトコルに変更することもあります。

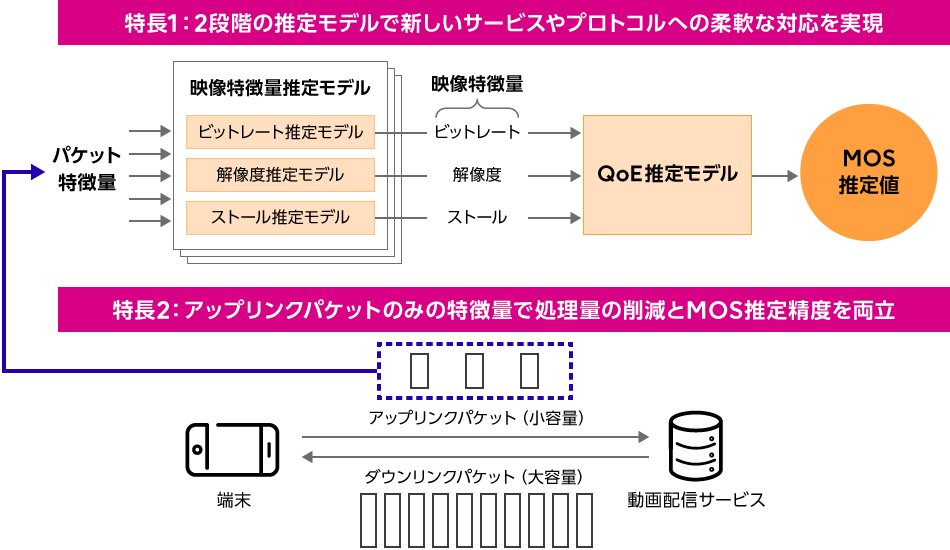

そこで、このようなサービスの多様性や変化に柔軟に対応するために、開発した「Realtime Quality of Experience Sensing」はビットレート、 解像度、ストール(映像の停止の有無)といったMOSを推定するための共通の特徴量を出力する映像特徴量推定モデルと、その共通の映像特徴量からMOSを出力するQoE推定モデルの二段階のモデルで構成するアーキテクチャにしました。

前段の映像特徴量推定モデルは暗号化されているパケットの統計量などを特徴量として入力し、サービスや通信プロトコルに依存しない汎用的な映像特徴量を出力します。後段のQoE推定モデルはこの映像特徴量を入力とするため、サービスや通信プロトコルに非依存とすることができます。これにより、「Realtime Quality of Experience Sensing」は新しいサービスや通信プロトコルに対しても、前段のモデルのみを必要に応じて再学習や変更することで柔軟に対応することができます。

・高精度・リアルタイムな推定を実現する映像特徴量推定モデル

一般に、動画再生アプリケーションはネットワークの状態や再生バッファ内に蓄積されている映像データ量に応じて、映像の再生が止まらないように、取得する映像の品質を動的に変更しています。そこで、映像特徴量はネットワークを流れる暗号化パケットの時間的な変化に影響を受けると考え、時系列データの依存関係を扱うことができるニューラルネットワークモデルLSTM(Long Short-Term Memory)を用いました。

映像再生時に流れるパケットは膨大です。そこから特徴量を抽出するための計算量を減らすには対象とするパケットを減らす必要があります。そこで、動画再生アプリケーションの再生バッファの空きが増加した場合に、送信する映像要求パケットと実際に映像データを受信したときの映像受信応答パケットによって、再生バッファとネットワークの状態を表現できると考えました。この考え方に基づいて、本モデルではアップリンクのパケットを対象として、0.5秒毎のタイムスロットにおけるそれぞれのパケット数などの統計量をまとめたものを、特徴量ベクトルとしました。

このように、アップリンクのパケットのみの特徴量を利用することによって、全てのパケットを利用した場合よりも処理データ量を98%削減しながら、ほぼ同程度の精度で映像特徴量を推定することができました。開発した「Realtime Quality of Experience Sensing」は、動画配信の代表的な通信プロトコルであるHLS及びMPEG-DASHを用いた評価実験で、動画再生アプリケーションから取得した映像品質情報を用いたITUT P.1203の推定値に対して、85%以上で同等のMOSを推定できました。

図2:「Realtime Quality of Experience Sensing」のMOS推定アーキテクチャ

図2:「Realtime Quality of Experience Sensing」のMOS推定アーキテクチャ

開発者コメント

人工知能研究所 開発チームメンバー

大浦 淳貴

(Oura Junki)

和田 章宏

(Wada Akihiro)

二宮 照尚

(Ninomiya Teruhisa)

横尾 郁

(Yokoo Kaoru)

角田 潤

(Kakuta Jun)

小川 雅俊

(Ogawa Masatoshi)

私たちは、高解像度の動画配信サービスを快適に利用できるネットワークの実現を目指し、ユーザーのQoEを推定する技術の実現に取り組んでいます。様々なネットワーク環境で数百時間の動画を再生し、データの収集・分析を繰り返すことで、ようやく「Realtime Quality of Experience Sensing」という技術を確立することができました。今後拡がって行く仮想現実・拡張現実・複合現実などの次世代サービスへ展開し、映像を活用した高度なサービスを快適に利用できるようにしていきます。

今後について

本技術は、実環境における有効性検証のため、通信ネットワーク事業者を始めとするお客さまとのPoCで実証し、実用化を目指します。また、ネットワークリソースの最適制御技術を確立し、高品質なネットワークの効率的な提供を通じて人々の豊かな生活の実現や産業の発展に貢献します。

関連情報

・AIによる無線アクセスネットワーク運用管理の高度化(ホワイトペーパー)