自然言語処理エンジンに目を付けよう!

2021年6月21日

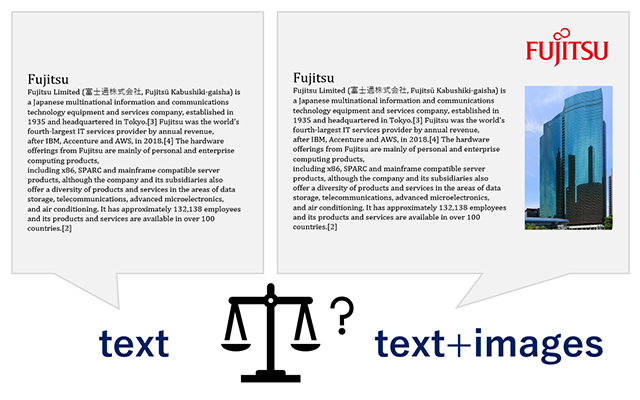

English人間はテキストや画像など様々な情報を総合的に組み合わせることで、ものごとを判断し理解する高度な知的処理を行います。このような人間の処理に対して、AI分野では一種類の情報(ユニモーダル情報)を用いる手法が主流でしたが、近年では、技術の発展に伴い、テキストや画像といった多様な情報(マルチモーダル情報)を組み合わせることで、現実世界のさまざまな概念を獲得させる動きが活発になっています。

富士通研究所はマルチモーダル情報活用に向けた取り組みの一環として、多言語のWikipedia記事分類タスクである SHINRA2020-ML ![]() にメルボルン大学と共同で参加しました。そこでマルチモーダル情報を用いたモデルにより、4言語で最高性能を達成しました。また、文書分類におけるテキスト情報と画像情報の組み合わせの効果を詳細に検証した結果が、自然言語処理分野のトップカンファレンスである国際会議EACL2021に採択され論文発表をしました。

にメルボルン大学と共同で参加しました。そこでマルチモーダル情報を用いたモデルにより、4言語で最高性能を達成しました。また、文書分類におけるテキスト情報と画像情報の組み合わせの効果を詳細に検証した結果が、自然言語処理分野のトップカンファレンスである国際会議EACL2021に採択され論文発表をしました。

テキストと図面はwikipediaより抜粋

https://en.wikipedia.org/wiki/Fujitsu

マルチモーダル情報を活用したい

自然言語処理の分野では、膨大な量のテキストデータをもとに学習された言語モデルが、様々な言語理解タスクを高い精度で解ける能力を有していることが知られてきています(参考文献 [1] [2])。しかし一方で、このような言語モデルは人間であれば簡単にわかるようなごく簡単な問題に失敗することがあります。たとえば、超巨大言語モデル GPT-3 の論文中 [2] では、モデルが “If I put cheese into the fridge, will it melt?” といった質問に正答できなかったことが報告されました。この質問に答えるには、冷蔵庫の温度、チーズが溶ける温度といった記載のあるテキストデータを用いればよいかもしれません。しかし、世界中のあらゆる物事についてそのすべての性質を記述したテキストを集めてモデルに学習させることは、コストや網羅性の観点から現実的ではありません。一方、人間はテキストだけでなく、画像や音声といった情報からも多くの知識を得ています。たとえば冷蔵庫に関して、色、形、機能、温度の全てを説明したテキストが無くても、冷蔵庫がどういうものかを実物を見て知ることができます。同様に、モデルに少数の冷蔵庫の画像を与えることで、テキストに記載がない冷蔵庫の様々な特徴に関する知識を補完できる可能性があります。我々はマルチモーダル情報活用の研究を通して、モデルにより多くの知識を効率的に与え、これまでに解けなかったタスクが解けるようになることを期待しています。

マルチモーダル情報、その中でもテキストと画像の情報を組み合わせて特定の問題を解くことは盛んに研究されるようになりましたが、それぞれの情報の役割やモデルの仕組みには未解明な部分が多くあります。今回、Wikipedia記事分類タスクを対象に、マルチモーダル情報が性能の向上にどのように寄与するかを検証しました。Wikipediaはテキストや画像といった多様な情報を含んでいるため、我々の検証の出発点として適当であると考えました。

自然言語処理エンジンに目(画像情報)を付けてみた

我々のモデルは Wikipedia のもつ多様な情報のうち、テキスト情報、画像情報、ページレイアウト、および Wikipedia に基づく知識グラフである Wikidata ![]() の情報を用いています。まずこれらの異なる情報をそれぞれ独立に用いて分類を行うモデルを学習し、複数の異なる文書ベクトルを獲得します。最終的にこれらの文書ベクトルを入力とした統合分類モデルを学習し、最終的な出力結果を得ました。

の情報を用いています。まずこれらの異なる情報をそれぞれ独立に用いて分類を行うモデルを学習し、複数の異なる文書ベクトルを獲得します。最終的にこれらの文書ベクトルを入力とした統合分類モデルを学習し、最終的な出力結果を得ました。

Wikipedia 記事分類タスク SHINRA2020-ML ![]() において、我々は28言語の分類タスクに参加し、提案モデルはこのうち4言語において、テキストを主な入力とする他のモデルを超える性能を達成しました(英語: 4チーム中1位、スペイン語: 5チーム中1位、イタリア語: 5チーム中1位、カタルーニャ語: 3チーム中1位)。これにより、多様な情報の利用が文書分類の性能向上に貢献する可能性が示唆されました。自然言語処理エンジンに「目」、すなわち画像情報を付けると、この新しい情報による一定の寄与が確認されました。

において、我々は28言語の分類タスクに参加し、提案モデルはこのうち4言語において、テキストを主な入力とする他のモデルを超える性能を達成しました(英語: 4チーム中1位、スペイン語: 5チーム中1位、イタリア語: 5チーム中1位、カタルーニャ語: 3チーム中1位)。これにより、多様な情報の利用が文書分類の性能向上に貢献する可能性が示唆されました。自然言語処理エンジンに「目」、すなわち画像情報を付けると、この新しい情報による一定の寄与が確認されました。

次に我々は、テキスト情報と画像情報の分類精度への貢献について詳細に検証しました。5つの言語を対象に行った実験の結果、大規模なテキストからニューラルネットワークを学習する事前学習を用いていないモデルにおいては画像の付加により性能が向上するが、大規模なテキストで事前学習したモデルと組み合わせた場合、画像の付加による効果が薄くなってしまうことを確認しました。この結果がマルチモーダル情報を用いた研究において意義のある知見であると認められ、自然言語処理分野のトップカンファレンスであるEACL2021に採択されました。

国際会議NTCIR-15、EACL2021

SHINRA2020-MLタスクでの成果についてはNTCIR-15で、文書分類における画像情報の効果についてはEACL2021で採択され発表をしました。

The 15th NTCIR Conference on Evaluation of Information Access Technologies ![]()

(2020年12月8日~12月11日)

・タイトル:UOM-FJ at the NTCIR-15 SHINRA2020-ML Task

・著者:Hiyori Yoshikawa (Fujitsu Lab.), Chunpeng Ma (Fujitsu Lab.), Aili Shen (UniMelb), Qian Sun (UniMelb), Chenbang Huang (UniMelb), Guillaume Pelat (École Polytechnique), Akiva Miura (Fujitsu Lab.), Daniel Beck (UniMelb), Timothy Baldwin (UniMelb), Tomoya Iwakura (Fujitsu Lab.)

The 16th Conference of the European Chapter of the Association for Computational Linguistics ![]()

(2021年4月19日~2021年4月23日)

・タイトル:On the (In)Effectiveness of Images for Text Classification

・著者:Chunpeng Ma (Fujitsu), Aili Shen (UniMelb), Hiyori Yoshikawa (Fujitsu), Tomoya Iwakura (Fujitsu), Daniel Beck (UniMelb), Timothy Baldwin (UniMelb)

今後、モデルにおけるマルチモーダル情報の活用について更なる解析を進めるとともに、多様な情報に基づくより良い文書表現の獲得を目指し研究を更に進めていきます。

参考文献

[1] Devlin et al.: BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding ![]() . In NAACL, pp.4171-4186, 2019.

. In NAACL, pp.4171-4186, 2019.

[2] Brown et al.: Language Models are Few-Shot Learners. arXiv preprint arXiv:2005.14165, 2020.

本件に関するお問合せ

fj-shinra2020@dl.jp.fujitsu.com

EEA (European Economic Area) 加盟国所在の方は以下からお問い合わせください。

Ask Fujitsu

Tel: +44-12-3579-7711

http://www.fujitsu.com/uk/contact/index.html![]()

Fujitsu, London Office

Address :22 Baker Street

London United Kingdom

W1U 3BW