これまで人間でしかできなかった高度な画像認識や過去のデータからの高度な予測分析など、AIの用途は身近になってきました。企業の業務システムから一般のコンシューマが触れるサービスまで社会の中でAIの適用領域が広がるに伴い、私たちの生活はますます便利になっていますが、一方で倫理的な問題が生じてきます。AIシステムが不当に偏ったデータから学習を行うと、システムが下す判断も偏ったものになってしまうからです。

「現在のAIはデータ主導のテクノロジーです。データは中立的なものではなく過去の人間の偏見の入った意思決定の記録や、差別が存在する社会での出来事を反映しているため、それをAIが学習してしまうと、人種や性別による差別などの不合理な偏見をさらに増幅させてしまう可能性があります」と語るのは富士通研究所 トラステッドAIプロジェクトの中尾悠里です。

さらに富士通研究所の米国拠点(Fujitsu Laboratories of America:FLA)のAI Ethics GroupのRamya Malur Srinivasanは、「人間は原因と結果の関係を理解できますが、機械にはできません。これが、偏見が生じる理由の1つとなっています」と説明します。

先端技術の活用が進む米国では、一部の警察が導入している「犯罪発生予測AI」が議論を呼んでいます。過去の犯罪の時間、場所、内容のデータを利用して効果的な警官の配備などを可能にするシステムですが、その問題をSrinivasanはこう指摘します。

「このシステムは、犯罪履歴データを使ったアルゴリズムであるため差別的なバイアスが生じてしまいます。そのようなデータを使って犯罪率を評価することが適切かどうか、大きな議論になっています」

こうした事例は他にも見られます。例えば、米Amazon.comは人材採用の効率化を目的にAIシステムを導入しましたが、学習データに女性が少なかったことで女性を不当に低く評価してしまうことがわかりました。同社はその後、このAI採用システムの使用を停止しています。

このように、実社会で偏った意思決定を出すAIが使われている現状を踏まえると、その倫理的な改善のアプローチは急務です。「AIによる判断で差別が生まれることを回避するためには、まずはAIのモデルやデータセットに不当な偏見が入らないようにする必要があります」と中尾は述べます。

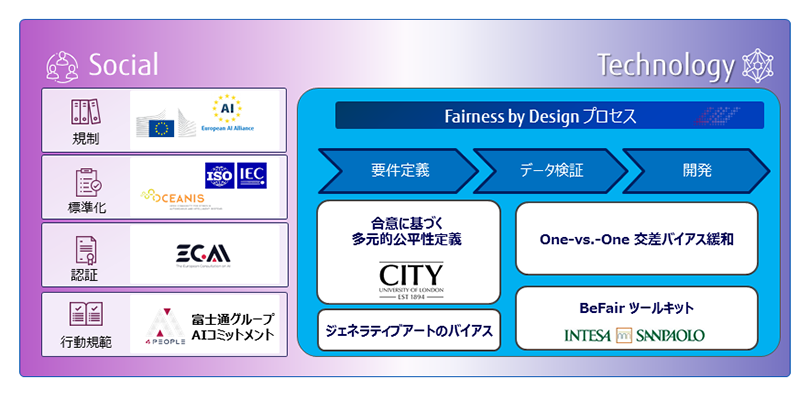

富士通は、DX企業として顧客の先の顧客(BtoBtoC)までを考えた価値提供を使命としているため、AIを安全・安心な形で社会に実装することは不可欠です。日本企業としては早期にAIの使い方についての指針を「富士通グループAIコミットメント」として発表し、現在AI倫理研究チームは日本、米国、欧州の3拠点で活動を行っています。

欧州では、富士通は2018年にAI倫理について話し合う有識者会議「AI4People」に設立メンバーとして参加し、AI倫理の取り組みを進めています。欧州は規制の動きが活発で、富士通も欧州人工知能協議会(ECAI)、EU AI Alliance、OCEANIS※1などに参加しています。

最先端の技術開発が活発な米国では、2017年に米国国防先端研究計画局(DARPA)が開始した「説明可能なAI(XAI:Explainable AI)」が中心の研究開発テーマとなっています。

AI倫理を構成する要素は公平性、アカウンタビリティ(説明責任)、透明性などがありますが、富士通は公平性について「Fairness by Design」の考えのもと、設計段階から公平性を確保するための開発プロセスの確立を進めています。この取り組みを進める中尾は、ロンドン大学シティ校と協業して、公平性要件抽出の研究を行っています。

「AI倫理の難しさの1つは、『公平とは何か』の答えが文化によって異なることです。そこで、文化的ダイバーシティ(多様性)を倫理の中に取り込みながら研究を進めています」と中尾は語ります。

※1…AIシステム開発のための標準規格に関心を持つ機関に議論の場を与える国際フォーラム。IEEE-SAが設立提案

富士通研究所では、これまでは3拠点それぞれで研究開発を進めていましたが、2020年にAI倫理チームを立ち上げ一本化しました。それまでの取り組みもあり、既に成果も出てきています。

例えば、中尾がロンドン大学シティ校との共同研究で展開したワークショップでは、日本、米国、英国においてAIを用いたローンの審査の合否を確認し、公平な判断と思うかどうかを議論し多くの発見があったといいます。

「傾向としては、米国と英国では公平であることとは『性別や人種に関係なく平等に扱うこと』と考えているのに対し、日本は『立場、スキル、経済的能力に関係なく平等に扱うこと』と考えていることがわかりました。また公平性の基準は欧米を中心に設計されており、現在では多様な公平性基準を考慮する枠組みがありません。ワークショップから明らかになった欧米と日本の文化の違いを踏まえ、公平とは何かを考えるフェーズに多様性を組み込む意義は大きいと感じています」(中尾)

富士通研究所では、技術的な観点からデータの不公平さを解消する研究開発も行っています。その1つが、「One-vs.-One Mitigation」と呼ばれる差別的バイアスの緩和技術です。例えば「女性」「黒人」など、単一の属性ではバイアスがないように見えても、「女性×黒人」など複数の属性が組み合わさると差別的なバイアスが顕著になる問題(Intersectional Bias)に対するもので、幅広い公平性要件に応じることができる技術です。「我々のチームの研究者が行った実験では、モデルの精度を維持しつつ、差別的なバイアスを排除できました」と中尾は報告します。

また、富士通研究所の欧州拠点(Fujitsu Laboratories of Europe:FLE)では、AI4Peopleの参加企業であるイタリアのインテーザ・サンパオロ銀行とともに実際のローン審査データを解析し、公平性を実装するツールキット「BeFair」を開発しています。FLE Artificial Intelligence & DA Research GroupのBeatriz San Miguel Gonzalezは、「様々なメトリクスからデータモデルの公平性を評価して、緩和のためのテクニックを比較できます」とその特徴を説明します。

AI倫理にて重要になる公平性に対して、技術的な側面だけではなく社会的な視点も含めながら研究に取り組んでいるのが、富士通研究所の特長です。

AI先進国の米国で研究活動をするSrinivasanは、「富士通研究所が突出している点は、課題を早期に特定し取り組んでいるところです。AI倫理は多くの企業が手掛け始めていますが、文化の違いを考慮に入れるというのは富士通が最初でしょう」と述べます。

Srinivasanは、芸術作品をAIによって生成するジェネラティブアートの研究も行っており、そこから得られた視点もあるといいます。

「例えばユーザーが写真をアップロードすると、あたかもゴッホなど芸術家の作風の絵に変換するアプリがあるのですが、そこでは肌の色が白く処理されます。これはルネッサンス期の人物画が学習データになっているからです」とSrinivasanは説明します。この研究の独自性が認められ、米国コンピュータ学会(ACM)の「ACM Conference on Fairness, Accountability, and Transparency」に採択されました。

このようなオリジナルな視点は、多様なメンバーとボトムアップの文化があってこそ、と3人は口を揃えます。中尾は大学、大学院で自然科学と社会科学の両方を学んでおり、ITにおける社会的な問題に取り組んできました。「コンピュータサイエンス分野の研究者に、公平性や多様性などの問題について理解してもらうことはとても難しいですね」と、オリジナルな視点だからこその苦労を明かします。

インドで電子通信分野を学び、米国で博士号を取得したSrinivasanは、卒業後富士通研究所に入社、AI倫理に出会うまではヘルスケア分野やXAIの研究をしていました。

「AI倫理に限ったことではありませんが、ある領域がひとたび課題であると認識されると皆が一斉に取り組み、短期間に研究がなされ、論文が発表されてすぐに成熟します。その流れの中で一定のレベルで興味を維持することは簡単ではなく、フラストレーションを感じることもありますが、面白いところでもあります」とSrinivasanは研究職の面白さを説明します。

スペインに在住するGonzalezは、学生時代にソフトウェアエンジニアリングの研究でユーザー中心のアプローチを取り入れ、博士号を取得した後、金融機関でビジネスアナリストとして勤務しました。その経験が現在の銀行との共同研究に活きているといいます。

「研究にコンピュータソフトウェアの知識は不可欠ですが、人間が使う以上、社会的側面も欠かせないと感じています。それでも、AI倫理のための複雑な方程式を理解することは簡単なことではありませんね」とGonzalezは苦笑しながら話します。

富士通研究所は今後も、公平なAIシステムを実現するために、Fairness by Designのプロセスをさらに洗練させていきます。

「ワークショップでの学びを元にAIからの結果を評価するGUIを開発しました。次のステップとして、融資審査者やデータサイエンティストによるとらえ方の違いを調べる計画です」と中尾は語ります。さらに「IEEEやISOでAIシステムのライフライクルの標準化に向けた動きが進みつつあります。これらがうまくいけば、AI倫理を維持・保証できるAIシステムの開発が自然になるでしょう」と続けます。

また公平性だけではなく、説明責任など他の分野にもFairness by Designの考え方は応用できるといいます。「AIで使うデータのプライバシーも重要な問題ですので、研究をどんどん拡大していきたい」とGonzalezは意気込みます。

またSrinivasanは、「AI倫理についていえば、途上国の人もサポートするものでなければならないと考えています。そのほかの観点としては、AIプログラムを実行する膨大なコンピューティングリソースによるCO2排出など、環境問題の文脈からも考える必要を感じています」とより広い視点で将来を語ります。

「人を中心としたAI」を掲げる富士通。研究員の独自の視点を生かした社会起点の研究開発はこれからも続いていきます。