AIに潜むセキュリティリスクを分析する技術を開発

機械学習工学研究会(MLSE)より発行される機械学習システムセキュリティガイドラインで、開発した分析ツールを無償公開

2022年6月29日

近年、様々な分野でAIが利用されています。その一方で、AIを意図的に誤判断させたり、AIから訓練データやモデルの情報を盗み取ったりする、AI特有の攻撃の存在が指摘されています。これらの攻撃により、例えば自動運転のAIで運転の判断を誤ると交通事故を起こす可能性があります。また、AI開発者が労力をかけて構築したAIシステムが攻撃者の手元で複製され、攻撃者によって類似サービスを展開される恐れがあります。

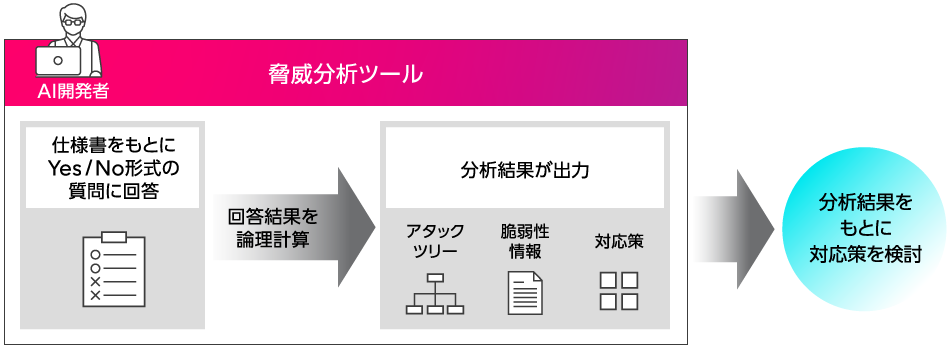

そこで、AIに潜むセキュリティリスクをAIシステムの開発者自身が分析することができるツールを開発しました。脅威となる攻撃の種類や、それらの攻撃を引き起こす要因などを分析し、アタックツリーで可視化して表示するとともに、対策案を提示することができます。

本技術は日本ソフトウェア科学会 機械学習工学研究会(MLSE)の機械学習システムセーフティ・セキュリティWGにおける機械学習システムセキュリティガイドライン策定委員会より、2022年6月30日に正式公開されるガイドラインVersion1.0に掲載し、分析ツールが同委員会より無償公開されます。

攻撃から守るにはAIセキュリティの専門知識が必要

様々な攻撃からAIを守る手段として、「AIシステムの内部処理の変更による防御手段」と「AIシステムの運用方法の変更による防御手段」の2つが考えられます。前者については、攻撃の検知や、モデルを強化するなどの方法で、学会等で様々な手法が提案されています。一方で、これらの手法は特定の攻撃に特化した技術が多く、様々な攻撃を受けるAIでは防御手段を確立することは困難です。

そのため、専用の防御手段を講じる前に、攻撃の機会そのものを減らす後者の「AIシステムの運用方法の変更による防御手段」も重要となっています。しかし、AIの開発者が開発の現場において、どのような運用を実施すべきかを判断することは難しく、AIセキュリティの専門家への相談が必要となる一方で、AIセキュリティの専門家は少なく、安全なAI開発における問題となります。

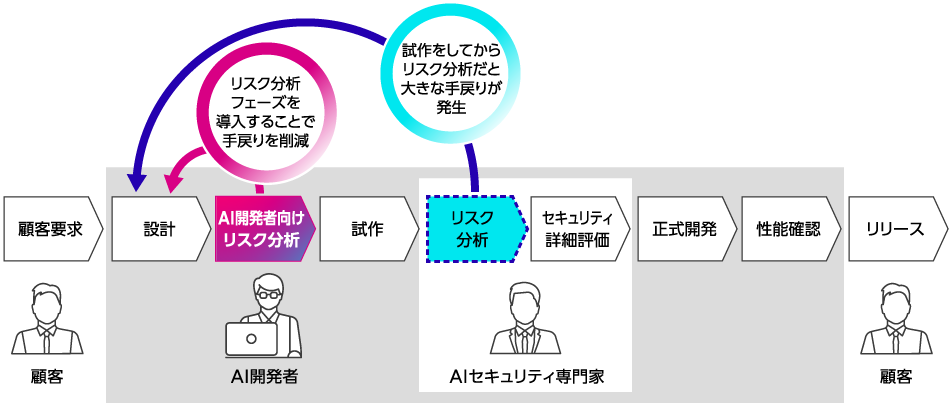

今回開発したAI開発者向けのリスク分析ツール使うことで、AI開発者自身がセキュリティリスク分析から対応策を検討することができるので、開発効率が向上するとともに、AIセキュリティ専門家の負担も減らすことができ、安全なAIの開発を効率的に行うことが可能になります。

図1.安全なAIを効率よく開発するための開発プロセス

図1.安全なAIを効率よく開発するための開発プロセス

被害を受ける攻撃が一目でわかるAIセキュリティアタックツリー

セキュリティリスク分析では、分析結果を元にシステムの仕様変更や、実施する運用防御を検討するといった重要な決断をするので、単に分析結果が表示されるだけではなく、どんな攻撃が何故実施できるのか、その要因を分析者が知ることが重要です。従来はAI特有の攻撃について、攻撃要因を可視化して表示する分析技術は存在していませんでした。今回、富士通研究所で培ってきたセキュリティ分野の知見と、AIセキュリティ分野の知見を組み合わせ、Yes/No形式質問に回答することにより、AI特有の攻撃要因を「アタックツリー」で可視化することに成功しました。

図2.開発技術によるセキュリティ分析概要

図2.開発技術によるセキュリティ分析概要

Yes/No形式の質問は、AI開発者が容易に回答できるように、システムの仕様に関する質問で構成しました。このような質問は、後述するアタックツリー内部にある条件と、システムの仕様を、AIセキュリティに関する攻撃手法の知見を基に結び付けることで作成しました。

質問内容の例は以下となります。

- 質問1: 想定攻撃者は準備した推論データ1000個以上に対して推論処理を実行することができますか?

- 質問2: 想定攻撃者にモデルの判定結果を提示しますか?

最大26問の質問に回答することでアタックツリー内部の条件を満たしているかどうかがわかるようになります。

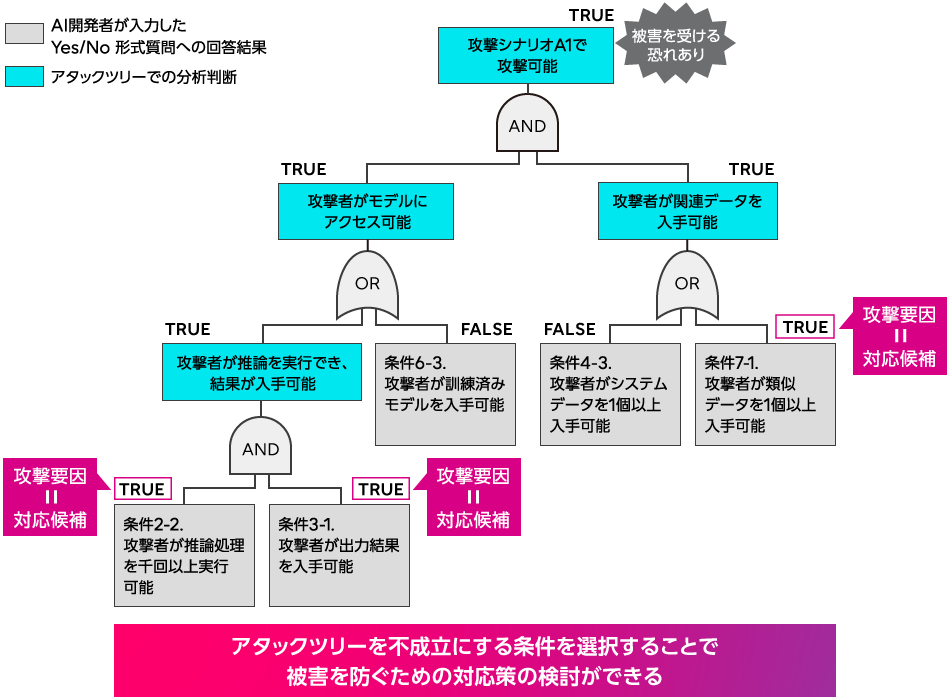

アタックツリーとは攻撃アルゴリズムを実行するための前提条件を論理関係で示したものです。今までは、AIセキュリティ分野において、詳細なアルゴリズム単位でアタックツリーを描いた例はありませんでした。今回、富士通研究所が所有しているAIセキュリティの知見を用いて、攻撃を実行するための前提条件を、論文に書かれているものだけでなく、書かれていない範囲まで補って抽出した上で、誤判定を抑えるような条件を設定し、アタックツリーを作成しました。

図3はある攻撃方法のアルゴリズムのアタックツリーです。このツリーの最上段がTRUE(成立)になると、その攻撃方法によって被害を受ける可能性があることを示しています。Yes/No形式の質問への回答により、ツリーの最下段に書かれている条件部分のTRUE(成立)/FALSE(不成立)が決まります。あとはツリーに従って論理計算をすることでツリーの最上段が成立するかどうか、つまりその攻撃によって被害を受けるかどうかが分かります。それと同時に何故その攻撃を受けてしまうのか、攻撃要因も明らかになります。

図3.アタックツリーによる攻撃要因の可視化

図3.アタックツリーによる攻撃要因の可視化

攻撃被害を受ける可能性があると判定されたツリーについては、ツリーを成立させている攻撃要因のいずれかを選択し、それに対応する対応策を採用することで、その攻撃要因を取り除き攻撃からの被害を受けにくくすることができます。

対応策の例は以下の通りです。もし対応策が採用できない場合には、AIセキュリティ専門家との相談によって適切な対策を講じます。

- 対応策1:

ユーザがデータ1000個以上に対して推論処理を実行できないようにする - 対応策2:

判定結果をユーザに提示しないようにする

今回、AIセキュリティの知見を活かして、防御対象の攻撃を代表的な22種に絞り込み、AI開発者が容易に自身のシステムのセキュリティリスクを分析することが可能となりました。

開発した分析ツールは、富士通が活動に貢献している日本ソフトウェア科学会 機械学習工学研究会(MLSE)より発行される、機械学習システムセキュリティガイドラインVersion1.0で公開されます。

多くのAIシステム開発者の方々に分析ツールを利用いただきフィードバックを受けることで、更なる分析精度の向上を目指します。

開発者コメント

データ&セキュリティ研究所 開発チームメンバー

矢嶋 純

乾 真季

笠原 史禎

及川 孝徳

辻 健太郎

森川 郁也

我々のプロジェクトでは、安心・安全なAIを開発するために、開発現場で利用できる実用的かつ、最先端のAIセキュリティ技術の研究開発を行っています。今回の技術はAIに潜む攻撃を可視化する脅威分析と呼ばれる枠組みの技術ですが、この枠組みにこだわらず、安全なAIのために必要なセキュリティ技術を開発していきます。最先端のAIセキュリティの研究を国際会議などで発表し、AIセキュリティ分野に幅広く貢献していきます。

今後について

本技術の分析対象範囲を広げ、より多くのAIを本技術で分析できるようになるよう、技術開発を進めていきます。また、MLSEにおけるガイドライン活動に今後も貢献し、AIの開発現場で活かせるセキュリティ技術の開発を進めていきます。

本件に関するお問い合わせ

contact-aiseceng@cs.jp.fujitsu.com

EEA (European Economic Area) 加盟国所在の方は以下からお問い合わせください。

Ask Fujitsu

Tel: +44-12-3579-7711

http://www.fujitsu.com/uk/contact/index.html![]()

Fujitsu, London Office

Address :22 Baker Street

London United Kingdom

W1U 3BW