本技术介绍参考了以下链接

English

2014年9月28日

将集群式超级计算机的网络交换机减少40%的技术

不牺牲网络性能,降低能源消耗

株式会社富士通研究所(注1)(以下简称,富士通研究所)开发了以下技术。

开发背景

目前,集群式超级计算机(注2)已被广泛应用于手机、汽车、飞机等的产品设计以及科学技术运算中,近几年,其应用已被扩大到制药、医疗、地震和气象分析等领域,因此需要更高性能的超级计算机。

要实现更高性能的超级计算机,需要连接更多的服务器。这些服务器上配有以多核处理器和GPGPU(注3)为代表的加速器,具有很高的运算处理性能。

课题

为了将超级计算机的高速运算性能应用于更广泛的领域,连接服务器的网络需要有更高性能。在胖树(Fat Tree)型网络拓扑中(图1),根据连接服务器的规模确定层级。而连接交换机的树型网络拓扑中的路径冗余实现了高性能网络,例如,连接6000台的服务器需要约800台36端口的交换机。

图1 Fat Tree型网络拓扑

Fat Tree结构由于路径冗余化,在PC集群上进行分析处理,比如高速傅立叶变换时,全服务器间的通信显示出了网络的高性能。

另一方面,各服务器的运算性能会随着处理器内核数量的增加,或GPGPU等加速器的使用迅速提高。为提高网络性能使之与运算性能对应,需要使用更多交换机,这将增加设备、电力、设置面积的成本,成为一大课题。

开发的技术

富士通研究所开发出了通过在PC集群上运用新的网络连接形态,寻找出优化的数据交换顺序,实现以较少的交换机对应更多个服务器的技术。与连接同等节点数的Fat Tree型网络构造相比,所需的交换机数约减少40%。并且在诸如全服务器间通信的最高负荷的通信模式时,也可以实现和传统方式同等程度的性能。

开发技术的特征如下:

1. 多层Full-mesh型网络拓扑(图2、图3)

开发了连接多个full-mesh结构的新构造,在full-mesh结构的各边,直连的两个交换机间加入用于间接连接的交换机。与3层结构的Fat Tree型网络拓扑(图1)相比,能减少1层的交换机,在提高交换机端口使用效率的同时,也减少了所需交换机的数量。

图2 多层full-mesh型网络拓扑(立体图)

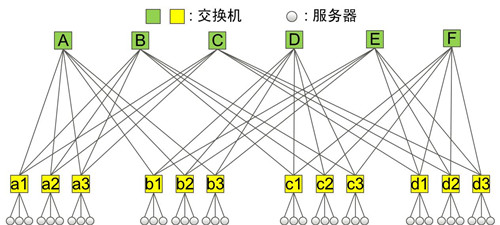

图3 多层full-mesh型网络拓扑(平面图)

2. 数据交换过程中避免路径冲突

在全服务器通信中,全部的服务器都将发送数据给其它所有的服务器,但是如果减少了交换机数,导致服务器间的路径减少,就会容易产生通信冲突。在服务器间的数据传输处理中,利用多层full-mesh型网络拓扑,通过调度,将连接各交换机的顶点(从A到F)的服务器转移至其它不同顶点下,同时避免不同层间(从a1到a3)的路径冲突,实现在全服务器通信时,达到Fat Tree型网络拓扑的相同性能。

效果

通过本技术,对于在制药、医疗、地震和气象分析等领域中使用的大规模PC集群型超级计算机,不但可以保持其性能,而且能够减少设备投资和电力成本,实现节能高效的超级计算机。

今后

富士通研究所目标在2015年度实现该技术的实用化。此外,还将继续研究,在不增加交换机数量的情况下,实现可用于更大规模计算机系统的架构。

注释

注1 株式会社富士通研究所:

社长 佐相秀幸

总公司所在地 日本神奈川县川崎市

注2 集群式超级计算机:

由众多PC服务器通过高速网络连接而成的超级计算机。

注3 GPGPU(General Purpose Graphic Processing Unit):

通用计算图形处理器。可以将用于图像处理的硬件应用于数值计算。也应用于具有高性能运算的超级计算机。