存档内容

注意:该页面为存档页面,其内容可能已过时。

针对深度神经网络的高速学习方法

富士通研究开发中心有限公司

联系方式

![]() 电话: 010-59691537

电话: 010-59691537

![]() 邮箱:multimedia@cn.fujitsu.com

邮箱:multimedia@cn.fujitsu.com

公司:富士通研究开发中心有限公司

信息技术研究部

新闻ID: 2016-11-22

日期: 2016-11-22

城市: 北京

公司:

富士通研究开发中心有限公司

注意:该页面为存档页面,其内容可能已过时。

富士通研究开发中心有限公司(FRDC)开发了一种适用于深度神经网络(Deep Neural Network)的快速学习技术。利用正则化策略,该技术能有效的降低深度神经网络模型的复杂度。此外,该技术还利用了二次近似方法来确定使模型收敛的最佳路径,从而提高了模型训练的速度。利用该技术,深度神经网络模型的学习时间可以缩短至50%。本项技术是一种适用于整个机器学习领域的通用优化技术,可广泛应用于各种应用场景。

作为人工智能(AI)的一个重要分支,深度学习技术在近年来取得了突破性的进展,并已成功应用于多个领域。然而,构建实用的深度神经网络模型常常涉及到海量的训练数据和复杂的模型结构,因而计算量大、计算时间长。例如:在语音识别领域,一个实用的语音模型往往包含上万个神经元,依赖几千个小时的语音数据对其进行训练,该训练过程需要几天甚至十几天的时间才能完成。由于深度神经网络模型的复杂性,有效的模型学习方法已成为关乎深度学习走向实用的一个重要基石。

深度神经网络模型主要由网络结构和网络参数两部分来确定。其中,网络结构包括网络层数、神经元数目、神经元连接方式等因素。而网络参数则指各神经元之间的连接权值(connection weight)。当网络结构确定之后,神经网络的学习其实就是寻找最优的网络参数值,即:神经网络通过学习过程所学到的“知识”都将蕴含在连接权值等网络参数中。

由于深度神经网络通常具有非常多的参数(数百万或更多),因此无法直接确定最优的网络参数值。事实上,我们只能利用优化的策略、通过迭代的方式来寻找近似最优的参数值。

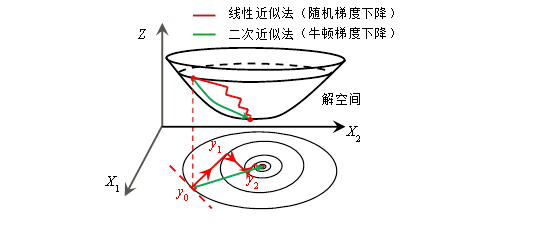

传统的基于线性近似(例如随机梯度下降法)的神经网络学习方法,由于只考虑梯度方向信息,因此导致“之”字形优化路径、收敛速度较慢,如图1中所示。二次近似方法(例如牛顿梯度下降法)虽然能以最短路径实现收敛,但是,由于高维空间中计算复杂度很高,所以不能直接使用。

在深度神经网络的学习中,为了确定最优的网络参数值,我们提出并开发了近接随机牛顿梯度下降法,该方法利用曲率和梯度信息构造正则化二次函数来实现迭代优化,从而减少迭代次数、加快了收敛速度。

如图1所示,通俗的讲,迭代优化就如同你希望找到一条最快的路径到达一个山谷的底部。在选择方向时,二次近似方法不仅考虑当前位置的坡度是否足够大,同时还考虑前进一步之后的坡度是否依然足够大,即目光更长远。

图1、线性近似与二阶近似优化方法示意图

二次近似方法虽然能有效减少迭代次数,但是,它的主要缺点是每一次迭代的计算复杂度太高。这是因为二次近似方法需要依靠矩阵运算、特别是矩阵的逆运算来完成,当神经网络中需要确定的参数的数目太多,即维度太高时,矩阵的逆运算将非常耗时。

为了提高计算效率,在每次迭代中,我们将二次近似函数从高维空间(百万级别的参数空间)映射到低维空间(几百维),在低维空间中计算逆矩阵及二次近似的最优值。之后,将低维空间中得到的计算结果映射回到原来的空间,以更新深度神经网络的参数值。如图2所示。

图2、低维空间投影

我们将正则化技术应用于深度神经网络的学习中,从而,确保模型的稀疏性,降低模型的复杂度。

图3给出了利用不同方法来学习深度神经网络模型的结果。该模型是一个4层的全连接模型,基于MNIST数据集进行学习(MNIST包含5万个手写数字样本,样本隶属于0-9等十个类别),以实现手写数字识别的功能。通过在手写字符识别的应用表明,我们FRDC开发的深度神经网络学习算法,PROXTONE(PROXimal sTOchastic NEwton-type gradient descent,近接随机牛顿梯度下降法)可以将模型的学习时间缩短50%以上。

图3、基于不同方法的DNN模型学习结果

富士通研发中心将进一步改进该技术的性能,以期实现神经网络模型的小型化和学习的高速化;同时,提高该技术在不同类型的神经网络模型上的适用性,将其应用于富士通的AI业务中。

联系方式

![]() 电话: 010-59691537

电话: 010-59691537

![]() 邮箱:multimedia@cn.fujitsu.com

邮箱:multimedia@cn.fujitsu.com

公司:富士通研究开发中心有限公司

信息技术研究部

新闻ID: 2016-11-22

日期: 2016-11-22

城市: 北京

公司:

富士通研究开发中心有限公司